什么是混合精度训练

1. 基本概念

混合精度训练(Mixed Precision Training)是指在深度学习模型训练过程中,同时使用不同精度的浮点数(通常是FP16和FP32)进行计算的技术。这种技术可以显著减少内存占用、提高计算速度,同时保持模型的训练精度。

2. 为什么需要混合精度训练

2.1 传统训练的问题

- 全精度(FP32)训练占用大量显存

- 计算单元利用率不高

- 训练速度受限于内存带宽

2.2 混合精度的优势

- 显存占用减少:FP16比FP32少用50%显存

- 计算速度提升:现代GPU对FP16有专门优化

- 训练吞吐量提高:可增大batch size或模型规模

3. 技术原理

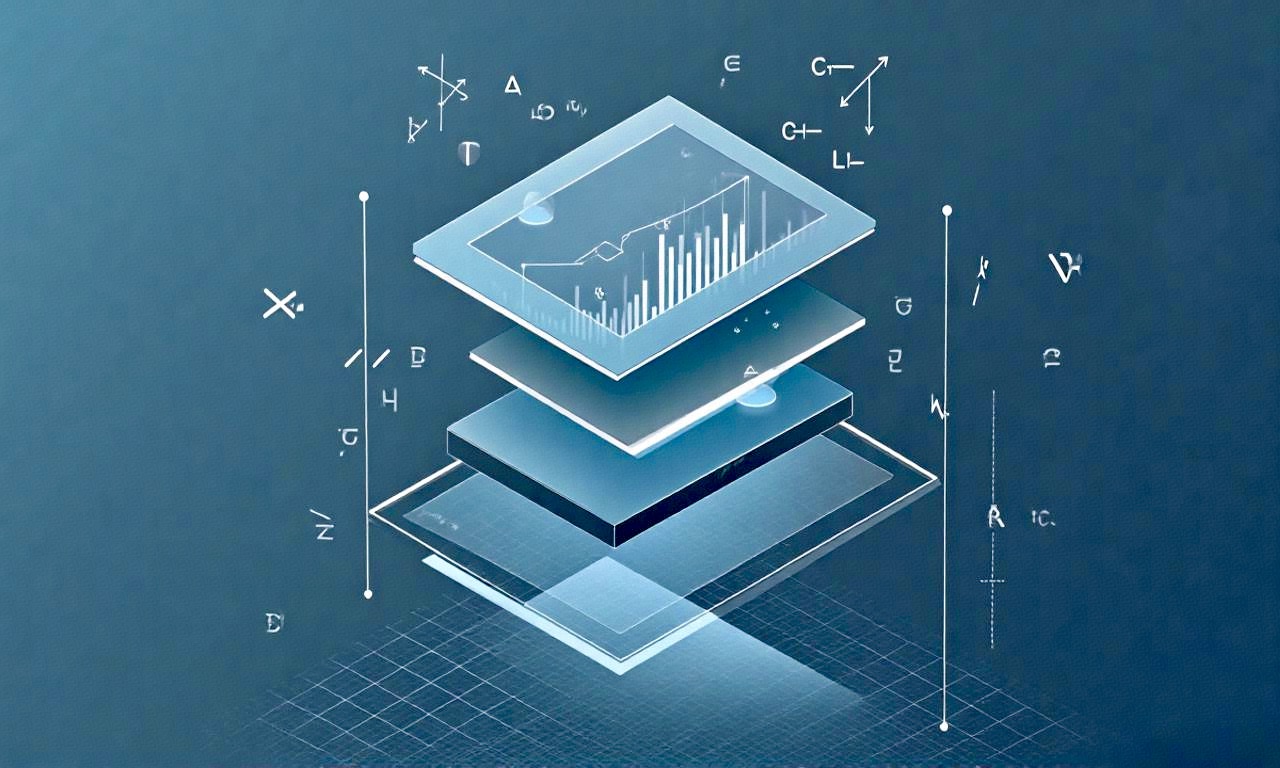

3.1 FP16与FP32对比

| 特性 | FP16 | FP32 |

|---|---|---|

| 比特数 | 16位 | 32位 |

| 指数位 | 5位 | 8位 |

| 尾数位 | 10位 | 23位 |

| 数值范围 | ±65,504 | ±3.4×10³⁸ |

| 精度损失风险 | 较高(容易出现下溢) | 低 |

3.2 混合精度实现方式

- 主要权重存储:使用FP32存储主权重(master weights)

- 前向传播:使用FP16计算

- 反向传播:使用FP16计算梯度

- 权重更新:将FP16梯度转换为FP32更新主权重

4. 关键技术:损失缩放(Loss Scaling)

由于FP16的数值范围有限,在反向传播时小梯度可能会下溢为0。损失缩放通过以下步骤解决这个问题:

- 前向传播时,将损失值乘以缩放因子(通常为8-1024)

- 反向传播时,梯度也会按相同比例放大

- 权重更新前,将梯度除以缩放因子恢复原比例

1 | # PyTorch中的损失缩放示例 |

5. 实际应用

5.1 NVIDIA AMP(Automatic Mixed Precision)

1 | from torch.cuda.amp import autocast, GradScaler |

5.2 适用场景

- 大规模模型训练(如Transformer、CNN)

- 显存受限的情况

- 需要提高训练吞吐量的场景

6. 注意事项

- 数值稳定性:某些操作(如softmax)仍需在FP32下进行

- 超参数调整:可能需要调整学习率和损失缩放因子

- 硬件要求:需要支持FP16加速的GPU(如NVIDIA Volta及以上架构)

7. 性能对比

| 指标 | FP32 | 混合精度 | 提升幅度 |

|---|---|---|---|

| 显存占用 | 100% | 50-60% | 40-50% |

| 训练速度 | 1x | 1.5-3x | 50-200% |

| 模型精度 | 基准 | 相当 | - |

8. 总结

混合精度训练通过合理利用FP16和FP32的优势,在保持模型精度的同时显著提升了训练效率。随着硬件对低精度计算的支持越来越好,混合精度训练已成为现代深度学习训练的标配技术。

评论